1、步骤一:了解robots.txt文件搜索引擎蜘蛛在访问一个网站时,会首先会检溽朽孑臾查该网站的根域下是否有一个叫做 robots.txt的纯文本文件。robots.txt文件作用是禁止搜索引擎抓取网站中某些内容。文件名必须是robots.txt(小写字母)。存放位置必须在空间根目录下,百度的robots.txt文件允许百度蜘蛛抓取网站部分页面。如网站允许抓取所有文件,可以不需要使用此文件。

2、步骤二:Robots.txt文件常用函数1、User-agent:制定规则适用于哪个蜘蛛。“*”代表所有搜索引擎。针对某个搜索引擎,则写该搜索引擎蜘蛛名称。

3、D坡纠课柩isallow:告诉蜘蛛不要抓取哪些文件和目录。例如上图淘宝robots.txt所示禁止百度搜索引擎抓取所有网敌颉缪莽页,代码如下:User-agent: BaiduspiderDisallow: / Disallow还可以表示允许抓取所有文件,代码如下:User-agent: BaiduspiderDisallow:注意:两段代码只差了一个斜杠“/”,但是意思是完全相反,切记。

4、Disallow禁止具体某个文件或目录,则写出该文件的绝对地址,不带域名。代码如下。意为禁止百度搜索引擎抓取http://www.xxx.com/ web/abc/xxx.html文件。User-agent: BaiduspiderDisallow:/web/abc/xxx.html

5、Disallow禁止多个文件,需分行描述。禁止同一类型网址网页,则可以使用通配符。代码如下,意为橐赎圻弹禁止百度搜索引擎抓取网址是以http://www.***com/index.php?开头的网页文件,和以http://www.***.com/ pop/开头并以.html结尾的文件。同时还禁止抓取JPG图片。“*”代表任意字符。$代表行结束符。User-agent: BaiduspiderDisallow: /index.php?*Disallow: /pop/*.htmlDisallow: /*.jpg$

6、根据上述规则,http://www.***.com/index.php?search=25和http://www.***.com/pop/123.html两个网页将不会被百度搜索引擎抓取。以JPG格式结尾的图片也将不再抓取。

7、Allow:告诉蜘蛛应该抓取哪些文件和目录。Sitemap:告诉蜘蛛XML网站地图在哪里。代码如下,允许所有的搜索引擎访问,并告知网站地图地址,网站地图域名为全网址出现。User-agent: *allow:http://www.***.com/1.htmlSitemap: http://www.***.com/sitemap.xml

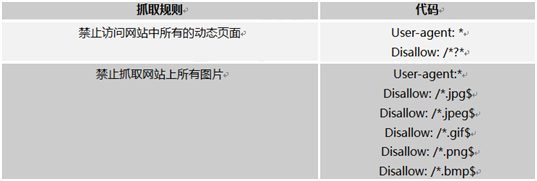

8、步骤四:robots.txt文件其他应用robots.txt文件用法举例

9、步骤五:robots.txt文件上传服务器将robots.txt文件上传至远程空间根目录下即可。